新的iOS 15将更新儿童安全功能,苹果公司(Apple)将利用神经匹配来识别iCloud上的虐待儿童的照片,WhatsApp对此表示担忧;WhatsApp负责人威尔(Will Cathcart)表示,这些即将到来的更新有可能破坏用户隐私,同时也表示WhatsApp不会使用这样的系统。

威尔建议,苹果公司最好允许其用户选择报告滥用的内容,这也是WhatsApp使用的方法之一;他表示,WhatsApp曾向国家失踪和被剥削儿童中心(NCMEC)报告了4万多起案件,并且不必违反加密规定。

他担心政府将能够利用该系统扫描他们想要控制的内容,因为不同国家对非法内容有不同的定义;还有存在另一个威胁,那就是间谍软件公司也会得到他们的技术来利用它。

Will this system be used in China? What content will they consider illegal there and how will we ever know? How will they manage requests from governments all around the world to add other types of content to the list for scanning?

— Will Cathcart (@wcathcart) August 6, 2021

苹果新检测技术

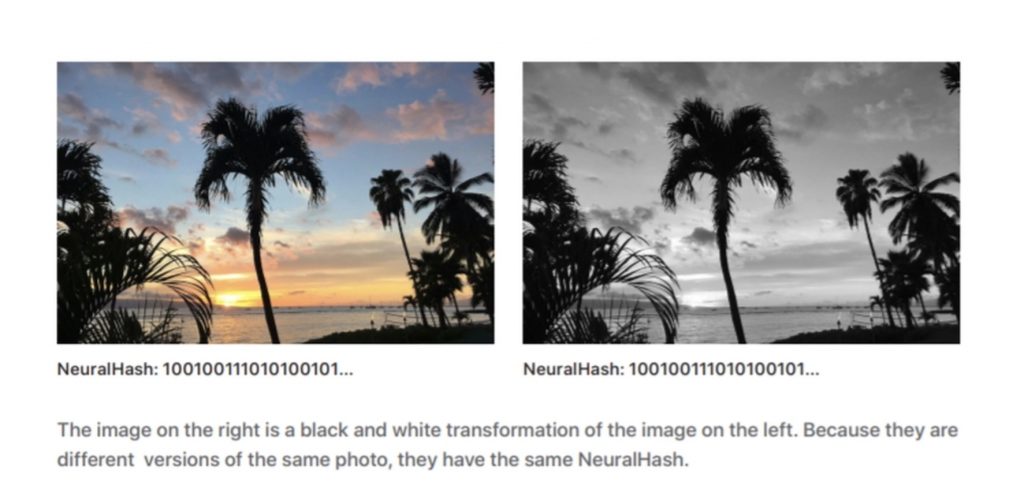

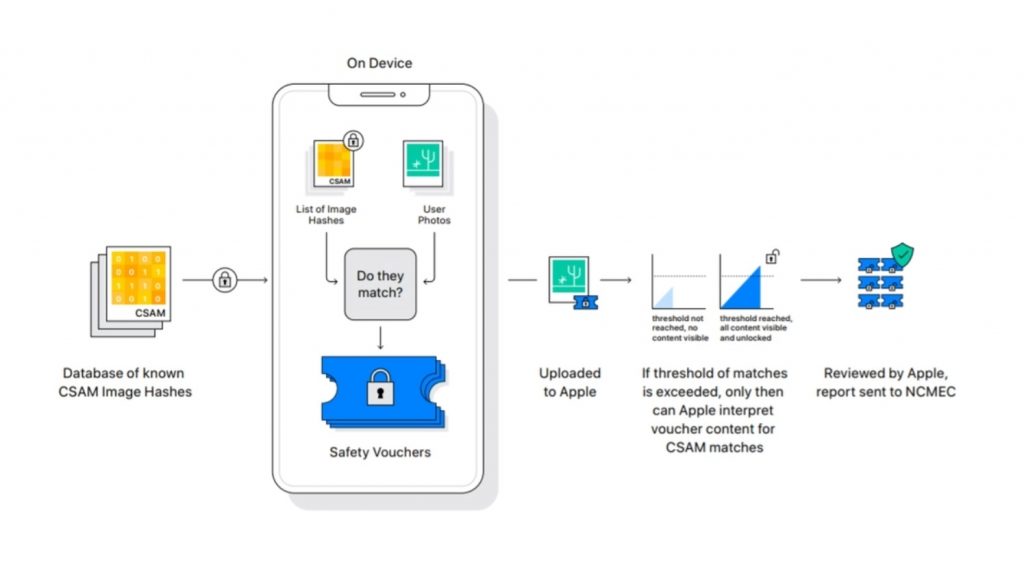

苹果表示,其新的NeuralHash检测工具将仍然能够保留用户隐私,同时限制传播剥削儿童的内容;该系统将把图像转换成二进制数字(也称为哈希),与已知虐待儿童材料的哈希数据库进行比较,以检测是否匹配。

苹果也说,终端用户将无法审查数据库,也无法知道是否检测到了匹配;没有数据库匹配的图像哈希(Image hash)基本上会被苹果忽略。

一旦有了匹配结果,就会出现加密安全凭证,其中包括照片的NeuralHash以及视觉衍生品,然后上传到iCloud;即使如此,苹果公司也只有在检测到大量匹配的情况下,才能解密安全凭证来调查可疑的图像。

一旦苹果公司核实该内容确实是剥削儿童的内容,它就会向国家失踪和被剥削儿童中心报告这些帐号。

苹果解释NeuralHash系统只适用于 iCloud Photos;审查该系统的密码学研究员班尼平卡斯(Benny Pinkas)表示,该系统只检测与数据库中已知图像的匹配。

他也在推特声称,检测发生在iCloud的服务器,但关于苹果公司检测虐待儿童内容的技术报告明确指出,匹配发生在设备本身。

一个假阳性的匹配?

另一位安全研究人员马修(Matthew Green)也评价了iOS 15的更新,表示这是一个坏主意;此前曾与苹果公司合作过的他表示,担心NeuralHash系统最终会被用作端到端加密设备的监控工具。

他还担心可能发生哈希碰撞( hash collisions),这可能会导致不匹配;不过,苹果公司曾表示,其系统非常准确,错误率低于每年1兆分之一的机会。

These images are from an investigation using much simpler hash function than the new one Apple’s developing. They show how machine learning can be used to find such collisions. https://t.co/N4sIGciGZj

— Matthew Green (@matthew_d_green) August 5, 2021

2013年,推特也开始使用其他类似的技术,名为PhotoDNA,该技术也将图片哈希与数据库进行比较,以淘汰描述虐待儿童的内容。

除了NeuralHash,如果通过Message应用程序(不要与iMessage混淆)发送或接收性虐待照片,iOS 15还将允许儿童及其父母获得警告通知;此功能将适用于设置为家庭的帐号。

Siri和Search也将更新,Siri可以协助用户报告虐待儿童的内容或剥削;如果用户搜索与儿童性虐待有关的照片,Siri和Search也将能够介入;他们将收到通知,会被告知他们的兴趣是不合适的,并向他们提供资源,以让他们寻求帮助。

除了iOS 15之外,这些更新也将适用于iPadOS 15、watchOS 8和macOS Monterey。